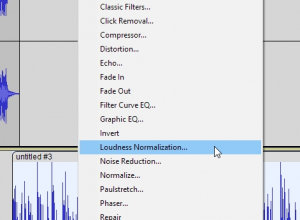

Bisher kannte ich die Möglichkeit, die Lautheit (nicht den Pegel) einer Spur festzulegen, nur aus Adobe Audition. Doch hier hat Audacity nachgezogen. Seit kurzer Zeit hat Audacity unter den Effekten die Funktion zum Anpassen der Lautheit. Die Anwendung ist relativ einfach. Man wählt das Sample, das angepasst werden soll, einfach aus, ruft die Anpassung auf und gibt vor, welche Lautheit die Anpassung einstellen soll. Wie alle anderen Effekte in Audacity – im Gegensatz zu Audition – kann es Effekte nur als Bearbeitungsfunktion, nicht als dynamische Funktion handhaben. Bei der Lautheit unterscheiden sich da Audacity und Audition nicht.

Bisher kannte ich die Möglichkeit, die Lautheit (nicht den Pegel) einer Spur festzulegen, nur aus Adobe Audition. Doch hier hat Audacity nachgezogen. Seit kurzer Zeit hat Audacity unter den Effekten die Funktion zum Anpassen der Lautheit. Die Anwendung ist relativ einfach. Man wählt das Sample, das angepasst werden soll, einfach aus, ruft die Anpassung auf und gibt vor, welche Lautheit die Anpassung einstellen soll. Wie alle anderen Effekte in Audacity – im Gegensatz zu Audition – kann es Effekte nur als Bearbeitungsfunktion, nicht als dynamische Funktion handhaben. Bei der Lautheit unterscheiden sich da Audacity und Audition nicht.

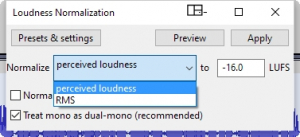

Allerdings muss man darauf achten, dass als Normalisierung die wahrgenommene Lautheit gewählt wird, was die Grundeinstellung ist. Zwar erlaubt Audacity nicht den Bezug zu den IBU-Rundfunknormen wie Audition, für den Hausgebrauch reicht es schon. Empfehlen würde ich für Podcasts die gute alte -16 LUFS-Vorgabe von Apple, die -14 LUFS bei Amazon halte ich für zu laut. Wenn man regelmäßig Jingles verwendet, sollte man diese einmal so normieren und danach erneut abspeichern. Verkürzt den Workflow gerade bei großen Sample erheblich.

Allerdings muss man darauf achten, dass als Normalisierung die wahrgenommene Lautheit gewählt wird, was die Grundeinstellung ist. Zwar erlaubt Audacity nicht den Bezug zu den IBU-Rundfunknormen wie Audition, für den Hausgebrauch reicht es schon. Empfehlen würde ich für Podcasts die gute alte -16 LUFS-Vorgabe von Apple, die -14 LUFS bei Amazon halte ich für zu laut. Wenn man regelmäßig Jingles verwendet, sollte man diese einmal so normieren und danach erneut abspeichern. Verkürzt den Workflow gerade bei großen Sample erheblich.

Nicht zum automatischen Anpassen, aber zum Ausmessen der Lautheit bietet sich das Youlead Loudness Meter an.